robots.txt 是一个搜索引擎爬虫协议文件,它的作用是告诉搜索引擎蜘蛛您网站的哪些页面可以被抓取,哪些页面不可以被抓取。robots.txt 是一种遵循漫游器排除标准的纯文本文件,由一条多多条的规则组成,没跳规则可以禁止或允许特定的搜索引擎蜘蛛抓取网站的制定文件路径下的文件。如果你没有进行设置,则默认所有文件都允许抓取。

robots.txt 规则包括了:

User-agent:爬虫的用户代理(UA) 标识符,可在此处查看。

Allow:允许访问抓取。

Disallow:禁止访问抓取。

Sitemap:站点地图。不限制条数,你可以添加数条 sitemap 的链接。

#:注释行。

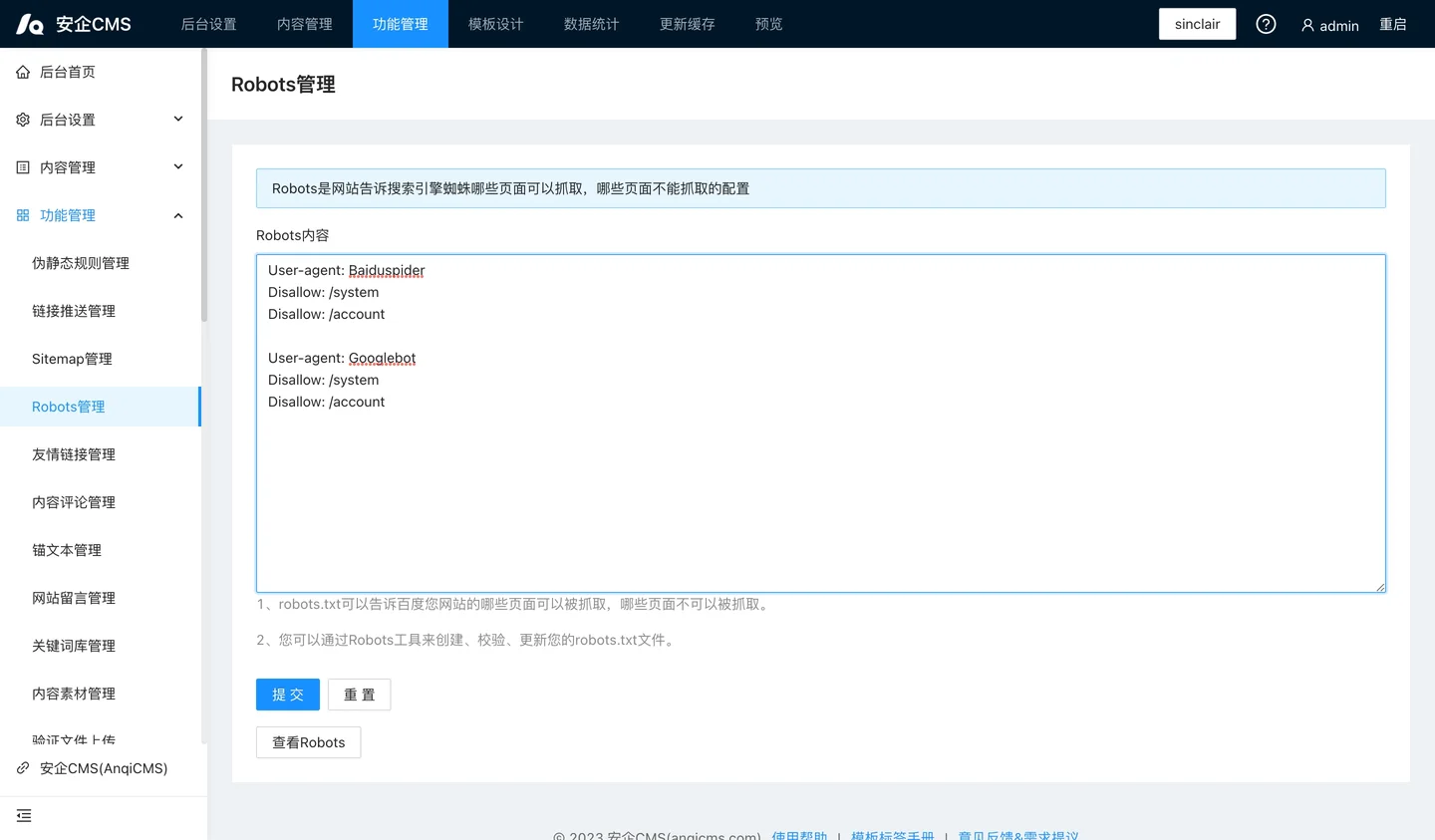

下面是一个包含两条规则的简单 robots.txt 文件:

User-agent: YisouSpider

Disallow: /

User-agent: *

Allow: /

Sitemap: /sitemap.xml

User-agent: BaiduSpider 行的意思就是:针对用户代理为“YisouSpider”(一搜搜索引擎爬虫)的规则,同样可以设置为 bingbot(必应)、Googlebot(谷歌)等等。其他搜索引擎爬虫的代理名字可在此处查看。

Disallow: / 的意思是“禁止访问抓取全部内容”。

User-agent: 行的意思就是:针对全部用户代理(* 为通配符)的规则。其他所有用户代理均可抓取整个网站。不指定这条规则也无妨,结果是一样的;默认行为是用户代理可以抓取整个网站。

Sitemap: 行的意思是:该网站的站点地图文件路径为 /sitemap.xml。